- Zyphra ZAYA1 se convierte en el primer modelo Mixture-of-Experts a gran escala entrenado íntegramente con GPU AMD Instinct™ MI300X, red AMD Pensando™ y software abierto ROCm.

- ZAYA1-base supera a Llama-3-8B y OLMoE en múltiples pruebas comparativas y rivaliza en rendimiento con Qwen3-4B y Gemma3-12B.

- La capacidad de memoria de AMD Instinct MI300X permitió a Zyphra simplificar sus capacidades de entrenamiento, al tiempo que logró tiempos de guardado del modelo 10 veces más rápidos.

AMD ha anunciado que Zyphra alcanzó un hito importante en el entrenamiento de modelos de IA a gran escala con el desarrollo de ZAYA1, el primer modelo fundacional Mixture-of-Experts (MoE) a gran escala entrenado utilizando GPU y plataforma de red de AMD. Con el uso de GPU AMD Instinct™ MI300X y red AMD Pensando™, y habilitado por la pila de software abierto AMD ROCm™, el logro se detalla en un informe técnico de Zyphra publicado hoy.

Los resultados de Zyphra muestran que el modelo ofrece un rendimiento competitivo o superior frente a los principales modelos abiertos en pruebas de razonamiento, matemáticas y programación. Esto demuestra la escalabilidad y eficiencia de las GPU AMD Instinct para cargas de trabajo de IA a escala de producción.

“AMD lidera la computación acelerada y está permitiendo a innovadores como Zyphra ampliar los límites de lo posible en IA”, afirmó Emad Barsoum, corporate vice president of AI and engineering, Artificial Intelligence Group en AMD. “Este hito demuestra la potencia y flexibilidad de las GPU AMD Instinct y de la red Pensando para entrenar modelos complejos y de gran escala”.

“La eficiencia siempre ha sido un principio rector fundamental en Zyphra. Define cómo diseñamos arquitecturas de modelos, desarrollamos algoritmos para entrenamiento e inferencia y seleccionamos el hardware con la mejor relación precio-rendimiento para ofrecer inteligencia de vanguardia a nuestros clientes”, señaló Krithik Puthalath, CEO de Zyphra. “ZAYA1 refleja esta filosofía y estamos encantados de ser la primera compañía en demostrar entrenamiento a gran escala en una plataforma AMD. Nuestros resultados ponen de relieve el poder de co-diseñar arquitecturas de modelos junto con silicio y sistemas, y estamos entusiasmados de profundizar nuestra colaboración con AMD e IBM mientras construimos la próxima generación de modelos fundacionales multimodales avanzados”.

Entrenamiento eficiente a gran escala, impulsado por GPU AMD Instinct

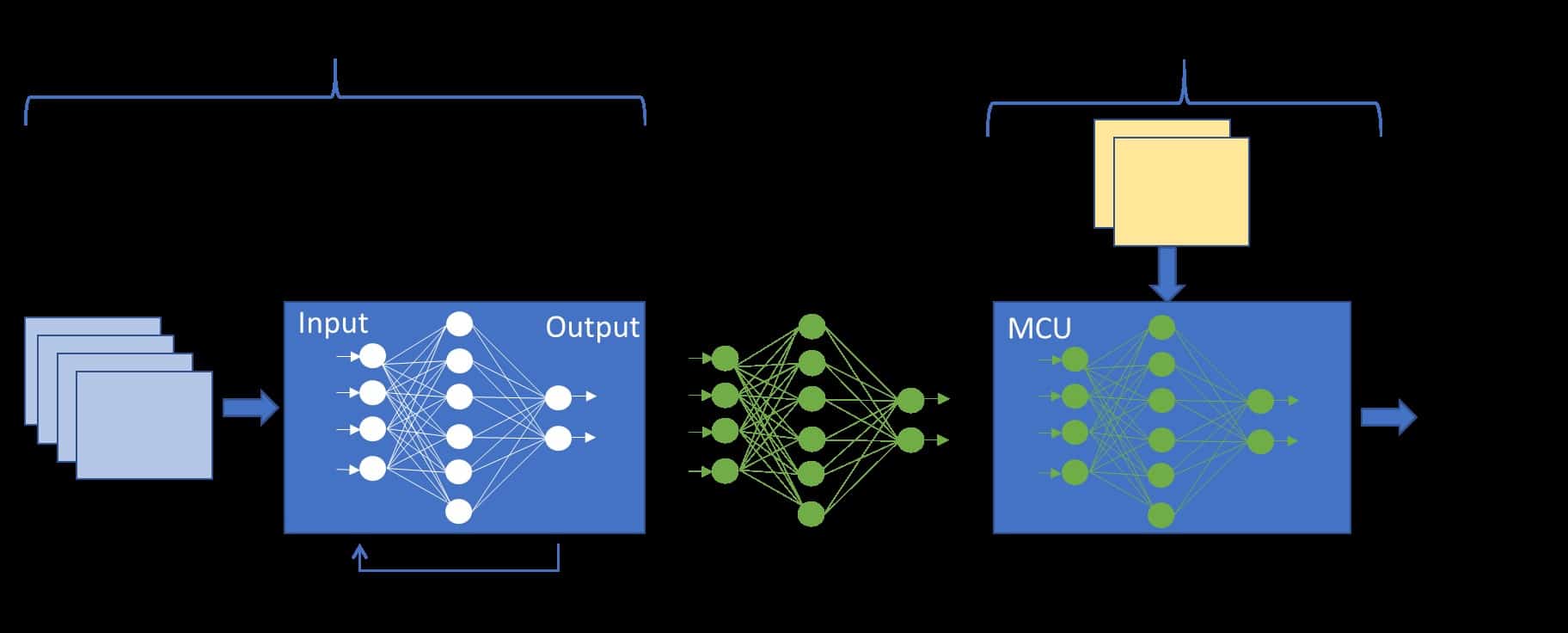

Los 192 GB de memoria de gran ancho de banda de la GPU AMD Instinct MI300X permitieron un entrenamiento eficiente a gran escala, evitando el costoso expert o tensor sharding, lo que redujo la complejidad y mejoró el rendimiento en toda la pila del modelo. Zyphra también informó de tiempos de guardado del modelo más de 10 veces más rápidos gracias al I/O distribuido optimizado por AMD, lo que reforzó la fiabilidad y eficiencia del entrenamiento. Con solo una fracción de los parámetros activos, ZAYA1-Base (8,3B en total, 760M activos) iguala o supera el rendimiento de modelos como Qwen3-4B (Alibaba), Gemma3-12B (Google), Llama-3-8B (Meta) y OLMoE.

Sobre la base de trabajos colaborativos previos, Zyphra trabajó estrechamente con AMD e IBM para diseñar y desplegar un clúster de entrenamiento a gran escala impulsado por GPU AMD Instinct™ con interconexión de red AMD Pensando™. El sistema desarrollado conjuntamente por AMD e IBM, anunciado a comienzos de este trimestre, combina GPU AMD Instinct™ MI300X con la arquitectura de tejido y almacenamiento de alto rendimiento de IBM Cloud, proporcionando la base para el preentrenamiento a gran escala de ZAYA1, evitando el costoso particionado de expertos o de tensores.

Para acceder a más detalles sobre los resultados, puedes leer el informe técnico de Zyphra, el blog de Zyphra y el blog AMD, para obtener una visión completa de la arquitectura del modelo ZAYA1, la metodología de entrenamiento y las tecnologías de AMD que hicieron posible su desarrollo.

Testing by Zyphra as of November 14, 2025, measuring the aggregate throughput of training iterations across the full Zyphra cluster measured in quadrillion floating point operations per second (PFLOPs). The workload was training a model comprised of a set of subsequent MLPs in BFLOAT16 across the full cluster of (128) compute nodes, each containing (8) AMD Instinct™ MI300X GPUs and (8) Pensando™ Pollara 400 Interconnects running a proprietary training stack created by Zyphra. Server manufacturers may vary configurations, yielding different results. Performance may vary based on use of the latest drivers and optimizations. This benchmark was collected with AMD ROCm 6.4.