L'AI Endpoints (ou TinyML) étant à ses débuts et lent à être adopté par l'industrie, de plus en plus d'entreprises intègrent l'IA dans leurs systèmes, par exemple pour la maintenance prédictive dans les usines ou la détection de mots clés dans l'électronique grand public. . Mais avec l'ajout d'un composant IA à votre système IoT, de nouvelles mesures de sécurité doivent être envisagées. L'IoT a mûri au point où vous pouvez lancer des produits de manière fiable sur le terrain en toute tranquillité d'esprit, avec des certifications telles que PSA Certified™ fournissant l'assurance que votre IP peut être protégée grâce à une variété de techniques telles que des moteurs de sécurité isolés, un stockage sécurisé des clés cryptographiques. et l'utilisation de l'Arm® TrustZone®. De telles garanties peuvent être trouvées dans les microcontrôleurs (MCU) conçus dans un souci de sécurité avec des fonctionnalités de sécurité matérielles évolutives, telles que la famille Renesas RA. Cependant, l'ajout de l'IA entraîne l'introduction de nouvelles menaces infestant les zones sécurisées, notamment sous la forme d'attaques contradictoires.

Les attaques contradictoires ciblent la complexité des modèles d'apprentissage en profondeur et les mathématiques statistiques sous-jacentes pour créer des faiblesses et les exploiter sur le terrain, entraînant la fuite de parties du modèle, la fuite de données de formation ou la génération de résultats inattendus. Cela est dû à la nature de la boîte noire des réseaux de neurones profonds (DNN), où la prise de décision dans les DNN n'est pas transparente, c'est-à-dire des "couches cachées" et les clients ne sont pas disposés à risquer leurs systèmes en ajoutant une fonction d'IA, ce qui ralentit la prolifération. des terminaux. Les attaques contradictoires sont différentes des cyberattaques conventionnelles en ce sens que dans les menaces de cybersécurité traditionnelles, les analystes de la sécurité peuvent corriger le bogue dans le code source et le documenter de manière approfondie. Étant donné que dans les DNN, il n'y a pas de ligne de codes spécifique que vous pouvez traiter, cela devient naturellement difficile.

Les attaques adverses dans la culture pop peuvent être vues dans Star Wars. Pendant les guerres de clones, l'Ordre 66 peut être vu comme une attaque contradictoire où les clones se sont comportés comme prévu pendant la guerre, mais une fois l'ordre donné, ils ont changé, provoquant une marée dans la guerre. .

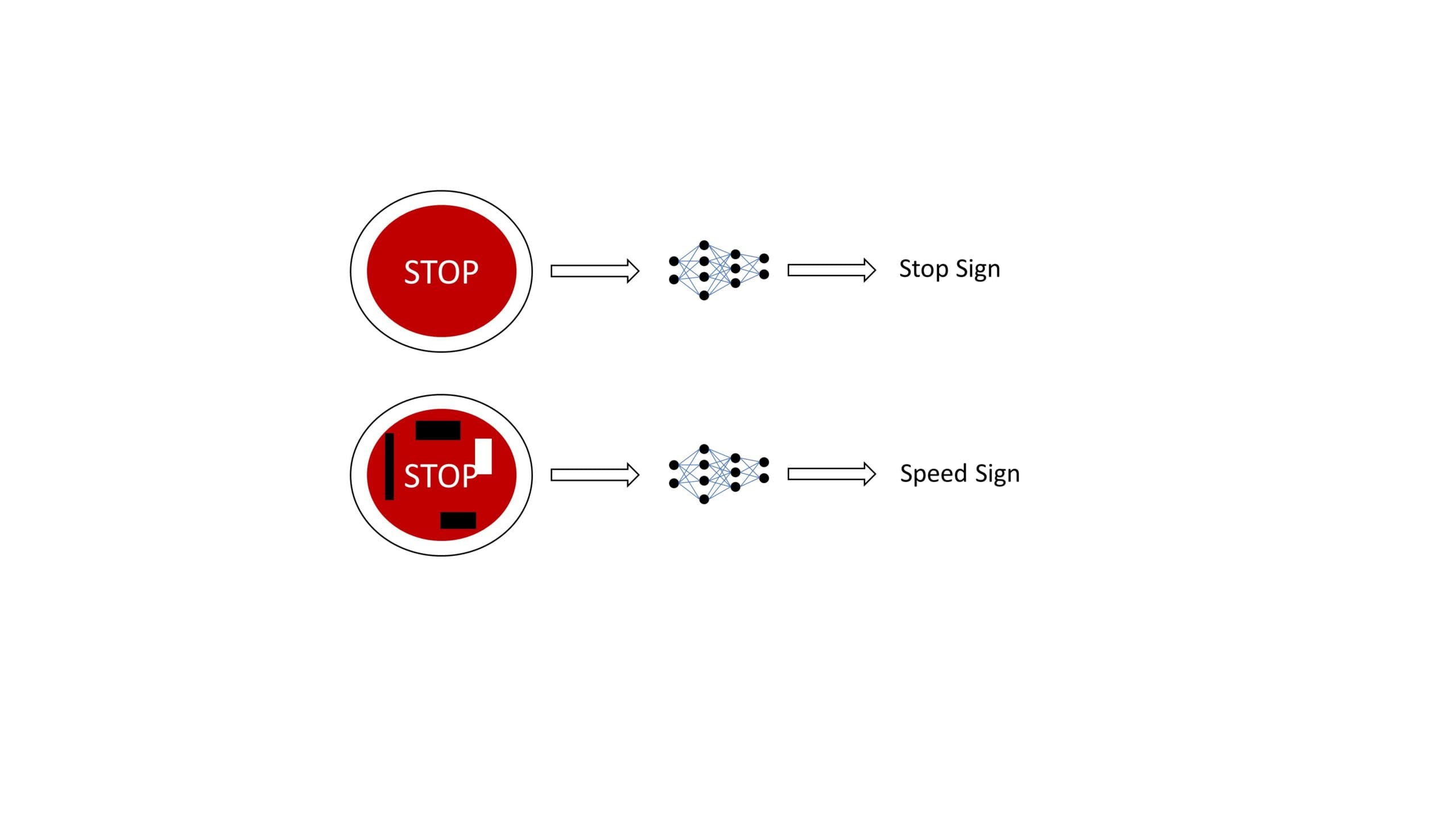

Des exemples notables peuvent être trouvés dans de nombreuses applications, comme une équipe de chercheurs collant des autocollants sur les panneaux d'arrêt, ce qui amène l'IA à le prédire comme un panneau de vitesse [1]. Une telle classification erronée peut entraîner des accidents de la circulation et une méfiance accrue du public à l'égard de l'utilisation de l'IA dans les systèmes. Les chercheurs ont pu obtenir 100 % d'erreurs de classification en laboratoire et 84,8 % lors de tests sur le terrain, ce qui montre que les autocollants étaient assez efficaces. Les algorithmes trompés étaient basés sur des réseaux de neurones convolutifs (CNN), de sorte qu'ils peuvent être étendus à d'autres cas d'utilisation utilisant CNN comme base, tels que la détection d'objets et la détection de mots clés.

Un autre exemple de chercheurs de l'Université de Californie à Berkley a montré que l'ajout de bruit ou de perturbation à n'importe quelle musique ou parole amènerait le modèle d'IA à l'interpréter à tort comme autre chose que la musique jouée ou à transcrire entièrement autre chose, mais cette perturbation est inaudible pour l'oreille humaine [2]. Cela peut être utilisé de manière malveillante dans des assistants intelligents ou des services de transcription IA. Les chercheurs ont reproduit la forme d'onde audio qui est similaire à plus de 99,9 % au fichier audio d'origine, mais peut transcrire n'importe quel fichier audio de leur choix avec un taux de réussite de 100 % en utilisant l'algorithme DeepSpeech de Mozilla.

Types d'attaques adverses

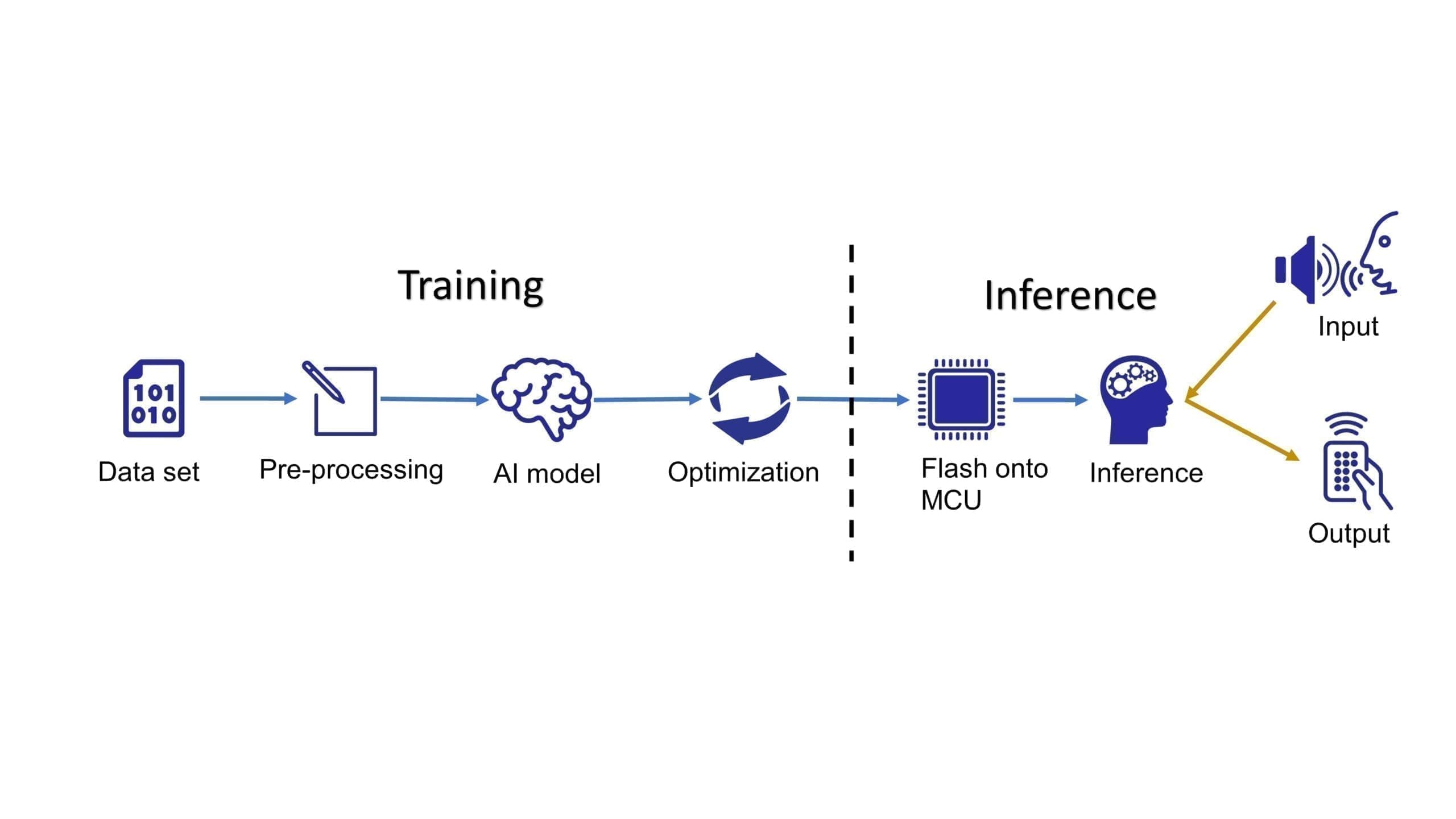

Pour comprendre les nombreux types d'attaques contradictoires, il convient d'examiner le pipeline de développement classique de TinyML, comme le montre la figure 3. Où la formation est initialement effectuée hors ligne, généralement dans le cloud, suivie de l'exécutable binaire final affiché sur le MCU et utilisé via des appels d'API. Le flux de travail nécessite un ingénieur en apprentissage automatique et un ingénieur embarqué. Étant donné que ces ingénieurs ont tendance à travailler dans des équipes distinctes, le nouveau paysage de la sécurité peut prêter à confusion quant à la répartition des responsabilités entre les différentes parties prenantes.

Des attaques adverses peuvent se produire dans les phases d'entraînement ou d'inférence. Pendant l'entraînement, un attaquant malveillant pourrait tenter un "empoisonnement du modèle", qui peut être ciblé ou non ciblé. Dans l'empoisonnement ciblé du modèle, un attaquant polluerait l'ensemble de données de modèle/d'entraînement de base de l'IA, entraînant une "porte dérobée" qui peut être déclenchée par une entrée arbitraire pour obtenir une sortie particulière, mais fonctionne bien avec les entrées attendues. La contamination pourrait être une petite perturbation qui n'affecte pas le fonctionnement attendu (comme la précision du modèle, les taux d'inférence, etc.) du modèle et donnerait l'impression qu'il n'y a pas de problèmes. Cela n'oblige pas non plus l'attaquant à prendre et à déployer un clone du système de formation pour vérifier l'opération, car le système lui-même était contaminé et affecterait de manière omniprésente tout système utilisant le modèle/l'ensemble de données empoisonné. C'était l'attaque utilisée contre les clones dans Star Wars.

L'empoisonnement du modèle sans cible ou les attaques byzantines se produisent lorsque l'attaquant a l'intention de réduire les performances (précision) du modèle et bloque l'entraînement. Cela nécessiterait de revenir à un point antérieur à la compromission du modèle/ensemble de données (potentiellement depuis le début).

En plus de la formation hors ligne, l'apprentissage fédéré, une technique dans laquelle les données collectées à partir des terminaux sont utilisées pour recycler/améliorer le modèle cloud, est intrinsèquement vulnérable en raison de sa nature décentralisée de traitement, permettant aux attaquants de s'engager avec des terminaux compromis menant au cloud. . le modèle est compromis. Cela pourrait avoir de grandes implications, car ce même modèle de cloud pourrait être utilisé sur des millions d'appareils.

Pendant la phase d'inférence, un pirate peut opter pour la technique "d'évasion de modèle", où il interroge de manière interactive le modèle (par exemple, une image) et ajoute du bruit à l'entrée pour comprendre comment le modèle se comporte. . De cette manière, le pirate pourrait potentiellement obtenir un résultat spécifique/requis, c'est-à-dire une décision logique après avoir ajusté son entrée suffisamment de fois sans utiliser l'entrée attendue. Une telle requête pourrait également être utilisée pour "l'inversion de modèle", où les informations sur le modèle ou les données d'apprentissage sont extraites de la même manière.

Analyse des risques pendant le développement AI TinyML

Pour la phase d'inférence, les attaques contradictoires sur les modèles d'IA sont un domaine de recherche actif, où les universités et l'industrie se sont alignées pour travailler sur ces questions et ont développé "ATLAS - Adversarial Threat Landscape for Artificial-Intelligence Systems !", qui est une matrice qui permet analystes en cybersécurité pour évaluer le risque de leurs modèles. Il comprend également des cas d'utilisation à travers l'industrie, y compris l'IA de pointe. L'apprentissage des études de cas fournies fournira aux développeurs/propriétaires de produits une compréhension de la façon dont cela affecterait leur cas d'utilisation, évaluera les risques et prendra des mesures de sécurité de précaution supplémentaires pour apaiser les préoccupations des clients. Les modèles d'IA doivent être considérés comme sujets à de telles attaques et une évaluation minutieuse des risques doit être effectuée par diverses parties prenantes.

Pour la phase de formation, s'assurer que les ensembles de données et les modèles proviennent de sources fiables réduirait le risque d'empoisonnement des données/modèles. Ces modèles/données doivent généralement être fournis par des éditeurs de logiciels réputés. Un modèle ML peut également être formé avec la sécurité à l'esprit, ce qui rend le modèle plus robuste, un peu comme une approche par force brute de la formation contradictoire où le modèle est formé sur de nombreux exemples contradictoires et apprend à se défendre contre eux. Cleverhans, une bibliothèque de formation open source utilisée pour créer de tels exemples pour attaquer, défendre et comparer un modèle d'attaques contradictoires, a été développée et utilisée dans le milieu universitaire. La distillation de défense est une autre méthode où un modèle est formé à partir d'un modèle plus grand pour générer des probabilités de différentes classes plutôt que des décisions difficiles qui rendent difficile l'exploitation du modèle par l'adversaire. Cependant, les deux méthodes peuvent être décomposées avec une puissance de calcul suffisante.

Protégez votre propriété intellectuelle d'IA

Parfois, les entreprises s'inquiètent des intentions malveillantes des concurrents de voler l'IP de fonctionnalité/modèle qui est stockée dans un appareil où l'entreprise a dépensé un budget de R&D. Une fois le modèle formé et peaufiné, il est converti en un exécutable binaire stocké sur le MCU et peut être protégé par des mesures de sécurité IoT conventionnelles, telles que la protection des interfaces physiques de la puce, le cryptage logiciel et l'utilisation de TrustZone. Une chose importante à noter cependant, même si l'exécutable binaire devait être volé, ce n'est que le modèle final poli qui est conçu pour un cas d'utilisation spécifique qui peut être facilement identifié comme une violation du droit d'auteur et une ingénierie inverse. que de commencer avec un modèle de base à partir de zéro.

De plus, dans le développement de TinyML, les modèles d'IA ont tendance à être bien connus et open source, tels que MobileNet, qui peuvent ensuite être optimisés via une variété d'hyperparamètres. Les ensembles de données, en revanche, sont conservés en toute sécurité car ce sont des trésors précieux que les entreprises dépensent en ressources pour acquérir et qui sont spécifiques à un cas d'utilisation donné. Par exemple, ajouter des cadres de délimitation aux régions d'intérêt dans les images. Des ensembles de données généralisées sont également disponibles en open source, comme CIFAR, ImageNet, etc. Ils sont utiles pour comparer différents modèles, mais des ensembles de données personnalisés doivent être utilisés pour le développement de cas d'utilisation spécifiques. Par exemple, pour un mot d'activation visuel dans un environnement de bureau, un ensemble de données isolé dans un environnement de bureau donnerait le résultat optimal.

Résumé

Alors que TinyML continue de croître, il est bon d'être conscient des diverses attaques qui peuvent se produire sur les modèles d'IA, de la manière dont elles pourraient affecter votre développement TinyML et des cas d'utilisation spécifiques. Les modèles ML ont maintenant atteint une grande précision, mais pour la mise en œuvre, il est important de s'assurer que vos modèles sont également robustes. Au cours du développement, les deux parties (ingénieurs ML et ingénieurs embarqués) partagent la responsabilité des problèmes de cybersécurité, y compris l'IA. Là où les ingénieurs ML se concentreraient sur les attaques pendant la formation et les ingénieurs intégrés assureraient la protection contre les attaques par inférence.

Pour le modèle de propriété intellectuelle (PI), un élément crucial consiste à garantir que les ensembles de données de formation sont conservés en toute sécurité pour empêcher les concurrents de développer des modèles similaires pour des cas d'utilisation similaires. Quant au binaire exécutable, c'est-à-dire le modèle IP sur l'appareil, il peut être protégé avec les meilleures mesures de sécurité IoT qui font la renommée de la famille Renesas RA, ce qui rend très difficile l'accès aux informations sécurisées dans un environnement malveillant. façon.